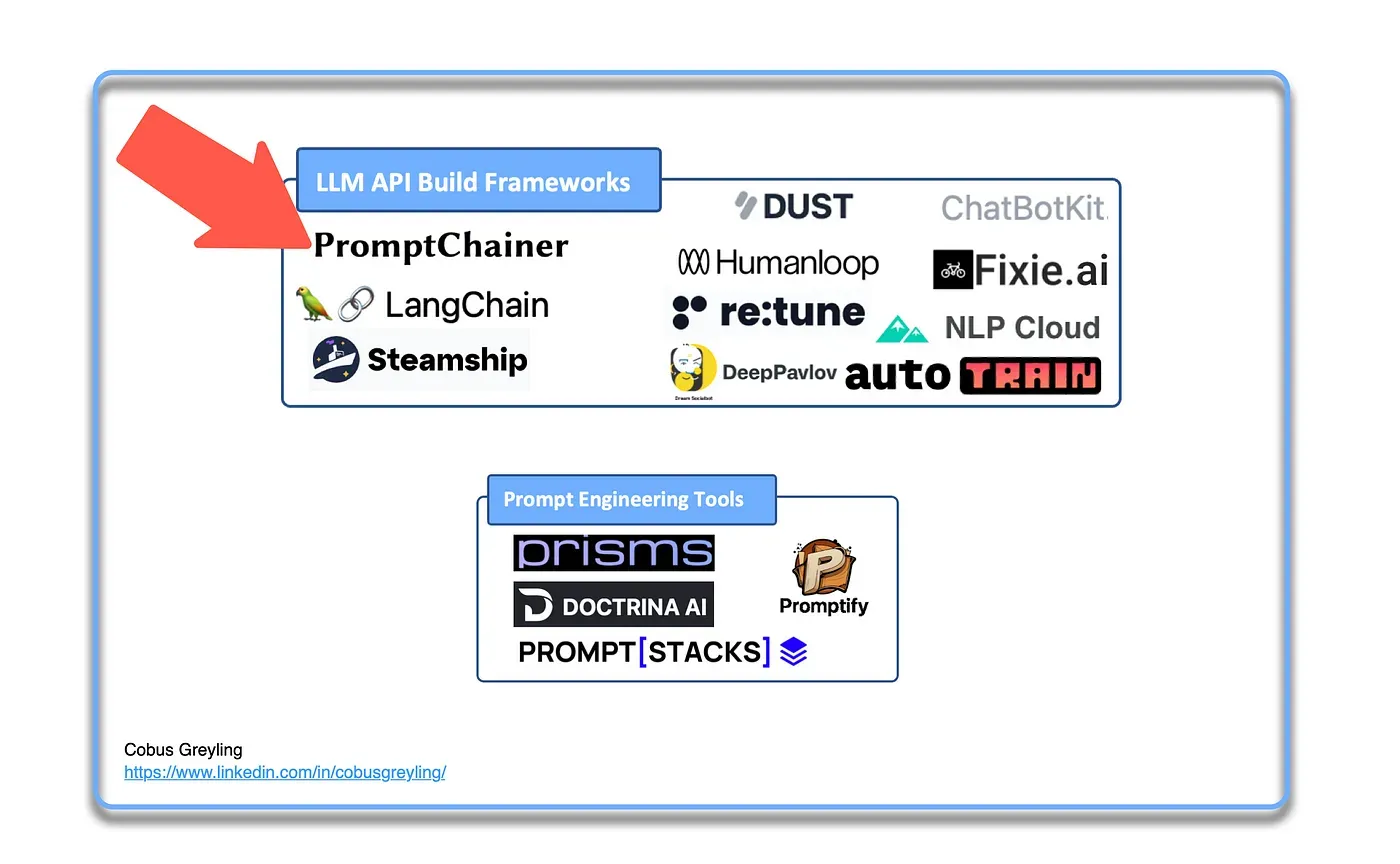

在上图中,我列出了当前的提示工程工具和LLM API构建框架。LLM构建框架的复杂性和可用性各不相同,但大多数框架都基于相同的链、提示、无代码到低代码和任务分解原则。在这些工具中,我认为PromptChainer是最先进和最完整的。

考虑到PromptChainer开发接口

随着LLMs在生产和产品环境中的采用,出现了两个术语,第一个是提示链,第二个是模板。

有些人将模板称为实体注入或提示注入。

LLMs已经导致了自然语言应用程序的快速原型,但是当应用程序包括复杂的对话、决策制定等时,单个提示是不够的。

因此,在各种框架中有一种概念,将多个LLM运行或提示链接在一起。目标是利用LLM的灵活性,以及可编程性和可控制的复杂性来完成更复杂的任务。

为了在商业应用程序中快速扩展生产采用,需要有一个无代码到低代码的环境来普及LLM和ai注入的应用程序。

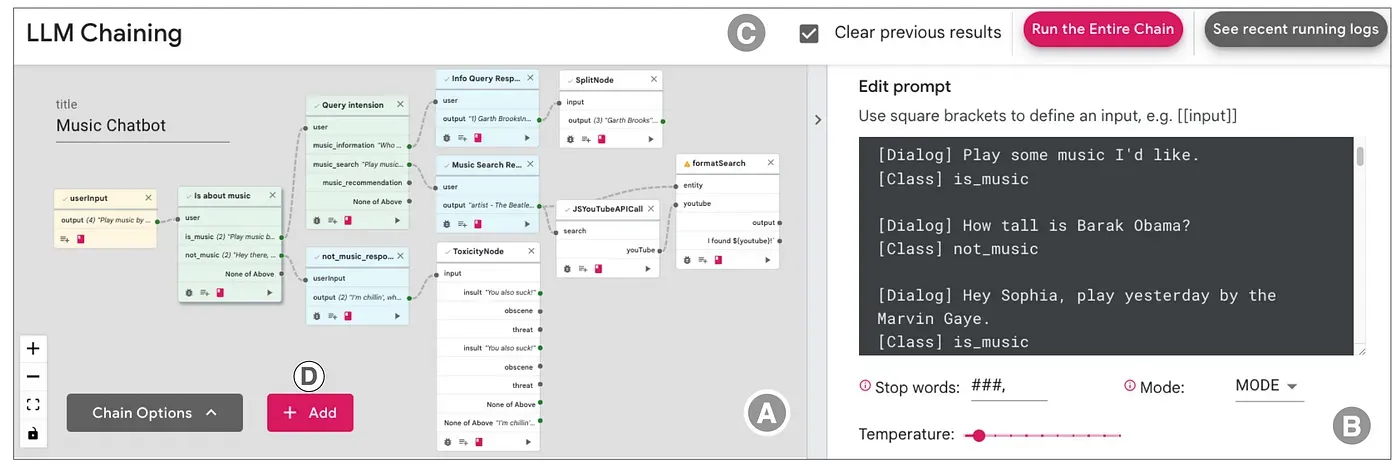

上图展示了迄今为止我见过的最完整、最全面的LLM应用程序开发gui之一。

A:链视图创建链,添加,删除,管理节点连接。

B:节点视图允许隔离地测试节点(提示)。

C:对话可以运行。

D:链条可以添加,编辑和更多。

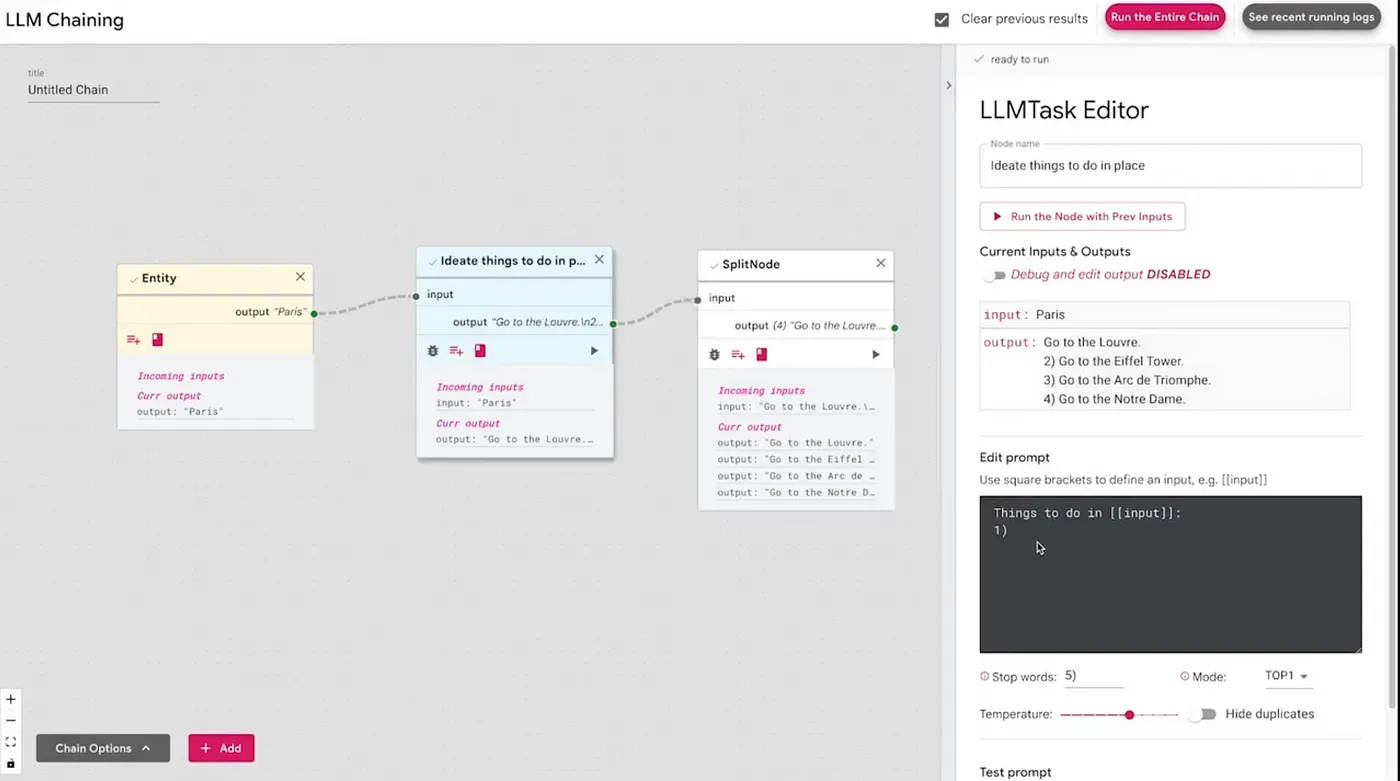

如下图所示:

会话流被分解为链接在一起的节点。选中中间节点,右侧显示“LLM任务编辑器”。您可以在模板界面上看到输入和输出。

模板提示的优点是:

LLM提示符可以重用、共享和编程。

1. 生成提示的模板允许提示的可编程性、存储和重用。

2. 模板,它充当文本文件,但会插入变量和表达式的占位符。

3. 占位符在运行时被替换为值。

4. 提示可以在上下文中使用,并且是控制生成内容的一种度量方法。

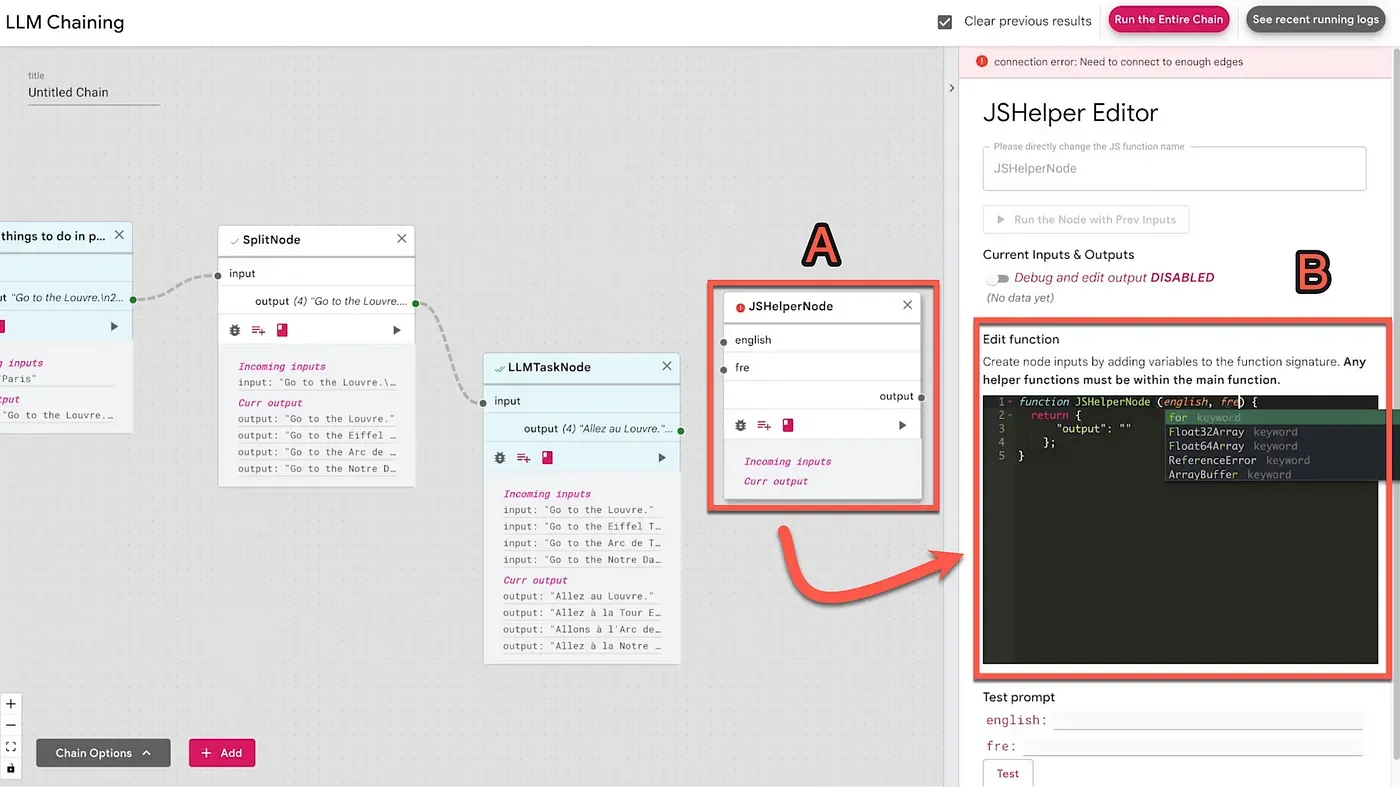

如上所示,通过右边的代码窗口(B),创建了一个JavaScript节点(a)来连接两对结果。

最终的想法

在LLM构建工具和大型语言模型之间也有一种新兴的抽象。

这允许Build Tools根据手头的任务使用一个或多个LLM。

这也提供了基于价格、性能、功能等从一个LLM迁移到另一个LLM的可能性。

使用简单的混合NLU和NLG方法将传统的基于意图的逻辑与动态LLM响应混合在一起,这是一个尚未开发的机会。

这种方法通过利用已开发的NLU模型,为现有的聊天机器人框架提供支持。

虽然LLM的生成能力不可否认,但在许多情况下,其预测能力可与NLU引擎相媲美。考虑成本、可访问性、训练数据、性能等等。

将LLM生成能力与传统NLU相结合似乎存在未开发的可能性。